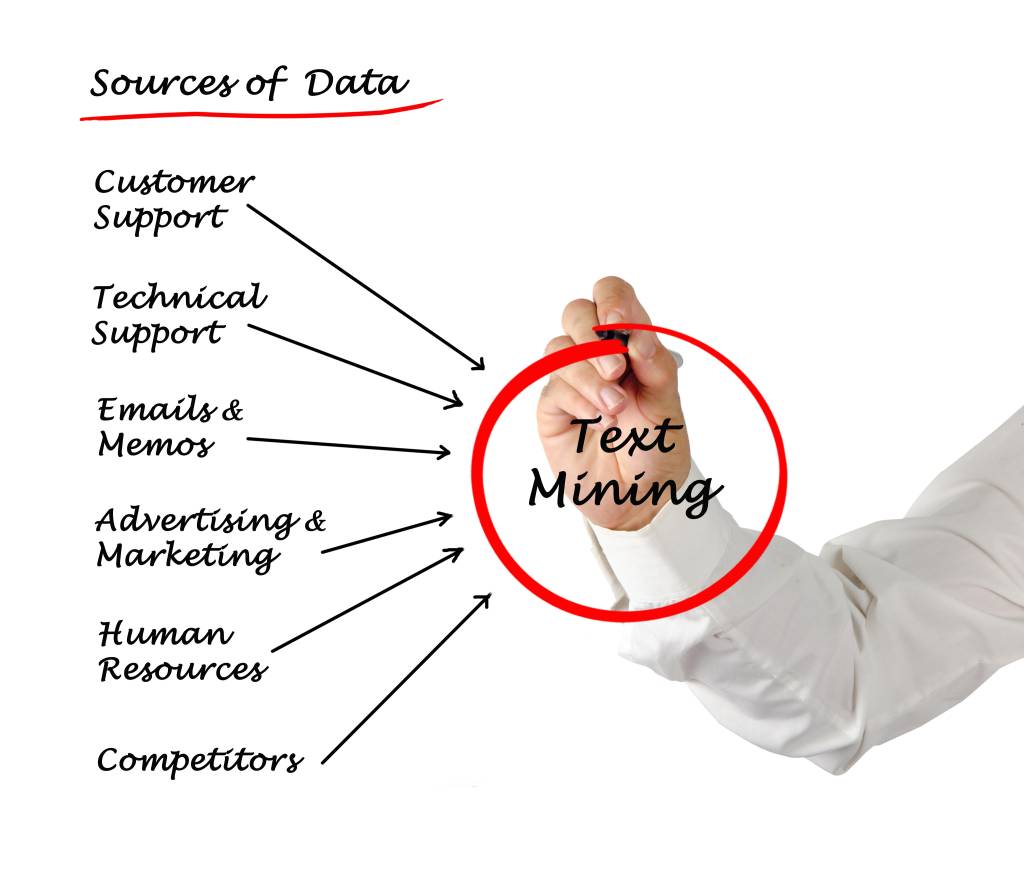

Im Jahr 1995 haben Ronen Feldman und Ido Dagan Text Mining als ‚Knowledge Discovery in Texts‘ in der wissenschaftlichen Community eingeführt. Heute ist die damit verbundene Technik breiter gefächert, meint aber immer das automatisierte Ableiten bestimmter hochwertiger Informationen aus vorhandenen Textdokumenten. Im Zeitalter von Big Data ist die automatisierte Verarbeitung textueller Informationen für Unternehmen von steigender Bedeutung. Denn Text Mining eignet sich für die Analyse unternehmenseigener, aber auch externer Dokumente. So kann damit etwa Spam in eingehenden Nachrichten herausgefiltert werden, was die Cybersicherheit erhöht. Weitere Anwendungsfelder sind das unternehmensinterne Wissensmanagement oder die Bearbeitung von Kundenreklamationen bei Produkten. Ziel ist immer die Gewinnung neuer Erkenntnisse für eine bessere Entscheidungsfindung. Es lohnt sich genau zu prüfen, welche Möglichkeiten es gibt, wie die Methoden aussehen, und welche Ansätze für welche Zwecke erfolgversprechend sind.

Grundlegende Arbeitsweise

Textdaten sind nicht formalisiert und das Ergebnis kann sehr unterschiedlich ausfallen, da es keinen einheitlichen Analyseansatz gibt. Das macht den effektiven Einsatz von Text Mining ebenso herausfordernd wie nützlich. Entscheidend ist hierbei die Wahl passender Methoden. Generell unterscheidet man beim Text Mining für jedes Dokument verschiedene Phasen:

- Bewertung der Relevanz zu einem vorgegebenen Thema oder einer Fragestellung,

- Spezifikation sogenannter Entitäten wie etwa Namen von Personen oder Produkten,

- Inhaltsanalyse bezüglich positiver oder negativer Bewertungen eines Themas,

- Spezifikation der Beziehung zwischen Fakten und anderen Entitäten wie Namen.

Zunächst müssen die zu untersuchenden Dokumente gesammelt und standardisiert werden. Die Ziele dabei sind die permanente Dokumentenerfassung und Gewinnung von Strukturdaten, das Sammeln von Metadaten wie Titel, Autor, Quelle, Typ und Erstellungsdatum sowie die Standardisierung von Texten und Metadaten. Nur in seltenen Fällen werden alle Dokumente formatgleich aus einem einzigen Quellsystem gezogen. Müssen diese beispielsweise gescannt werden, liegen sie als PDF vor, stammen aus Webquellen oder werden manuell von Benutzern hochgeladen, ist eine vorbereitende Behandlung in das entsprechende Format notwendig, die jedoch die spätere Bearbeitung und Qualität der Ergebnisse beeinflussen kann. Ist nur ein Bruchteil der Dokumente bzw. Informationen relevant, empfiehlt sich eine Vorauswahl über einen Volltextindex und eine Liste von Schlüsselwörtern. Werden dagegen Daten aus mehreren Quellen gesammelt, ist es besser, gleich auf eine standardisierte Schnittstelle wie etwa Solr zur Volltextsuche zurückzugreifen.

Klassifikation, Analyse und Training

Der relevante Dokumenten-Korpus wird dann einer Textnormalisierung und Vorverarbeitung unterzogen. Dabei werden die Texte nach Sätzen und Wörtern unterteilt. In vielen Sprachen müssen häufig vorkommende Stoppwörter, wie beispielsweise Artikel oder Präpositionen, herausgefiltert werden. Die verbleibenden Wörter werden auf ihre Grundform zurückgeführt. Die weitere Behandlung folgt mit unterschiedlichen Methoden, die jedoch auch in Kombination eingesetzt werden können, beispielsweise der Suche nach Entitäten und Beziehungen nach vorgegebenen Regeln sowie statistische Methoden und Machine Learning. Das Arbeiten mit Regeln wie ‚Suche nach Produktnamen, die innerhalb von drei Sätzen vor oder nach dem Firmennamen genannt werden‘ funktioniert eher in analytischen Sprachen wie Englisch. Deutsch ist dagegen eine synthetische Sprache, bei der Beziehungen auch mit Hilfe von Wortformen ausgedrückt werden.

Texte in numerische Form wandeln

Alternativ werden Texte statistisch oder mit künstlicher Intelligenz analysiert. Dazu werden sie zunächst in Vektoren umgewandelt. Bei der einfachen One-HOT-Codierung wird jedem Wort ein Vektor zugeordnet, der an jeder Position, die dem Auftreten des Wortes im Sprachwörterbuch entspricht, einen Wert ungleich Null bekommt. Das führt jedoch zu einer äußerst hohen Dimensionalität. Diese kann mit der Word2vec-Methode reduziert werden, da dort Wörter gleicher Bedeutung gleiche Vektoren haben. Bag-of-Words kennzeichnet die Worthäufigkeit in einem Text, ignoriert aber dessen Struktur. Die TF-IDF-Methode gibt die Worthäufigkeit im zu untersuchenden Text relativ zur Häufigkeit dieses Wortes im Dokumenten-Korpus an.