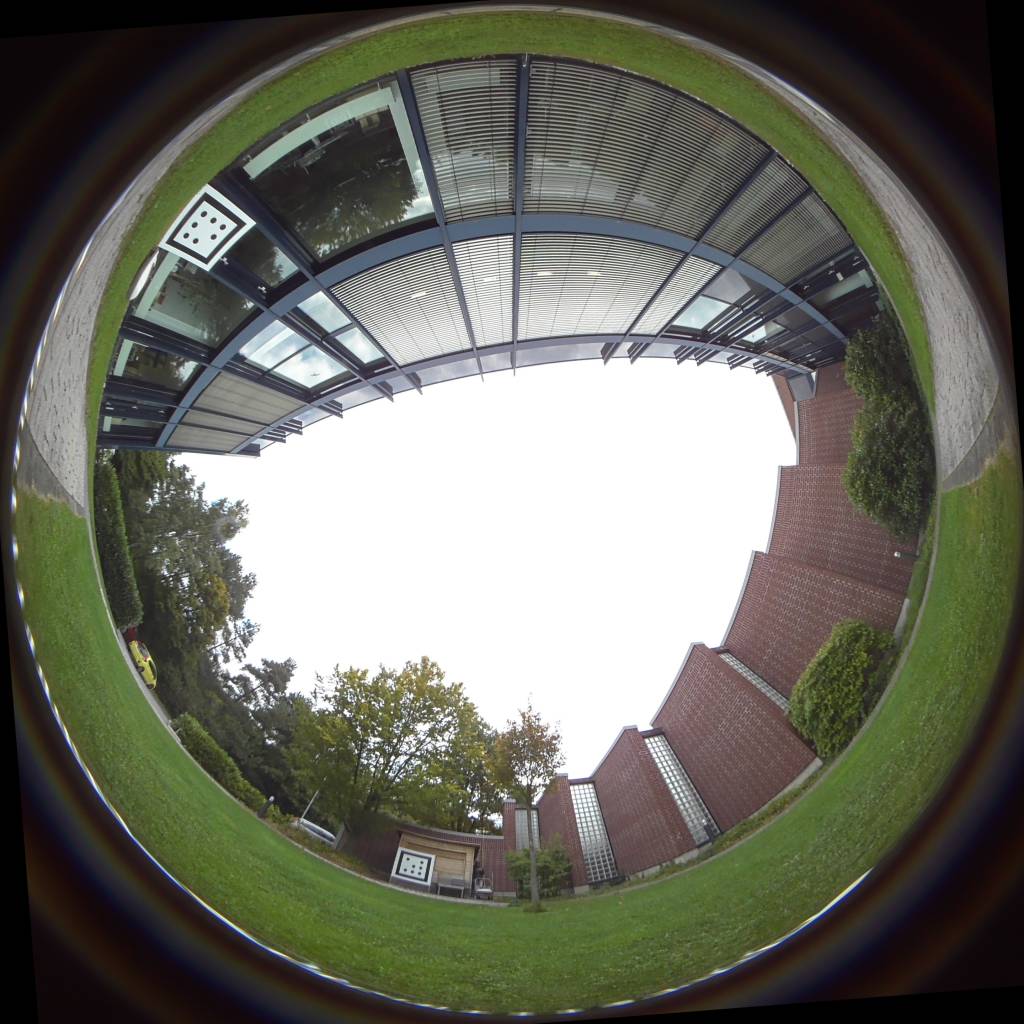

Prof. Dr. Ute Bauer-Wersing von der Frankfurt University of Applied Sciences forscht zur visuellen Selbstlokalisation und Navigation von mobilen Robotern in dem Kooperationsprojekt ‚Unsupervised Learning of Hierarchical Features for Visual Self-Localization and Navigation in Seasonally Changing Outdoor Environments‘ mit dem Honda Research Institute Europe. Das Forschungsteam entwickelt Lernalgorithmen, die kognitive Karten nachbilden, die zu den wichtigsten Komponenten des inneren GPS des Gehirns gehören. Die Forschungsarbeiten zeigen, dass eine präzise bis auf wenige Zentimeter genaue Lokalisation auf der Basis von Kamerabildern möglich ist.