Zehn Millionen Informationen kann das menschliche Auge innerhalb einer Sekunde aufnehmen. Dabei ist es so komplex wie kaum ein anderes Organ. Zusammen mit dem Gehirn verarbeitet es eingehende Informationen, leitet diese umgehend weiter und bildet die Welt optisch ab – ähnlich einer Filmkamera. Der Sehsinn erlaubt es, ein breites Spektrum an Aufgaben zu erledigen, vom Griff nach der Kaffeetasse bis hin zu feinmechanischen Präzisionsarbeiten wie der Montage eines Uhrwerks. Dabei stecken selbst hinter intuitiven Handgriffen hochkomplexe Prozesse.

Nur so intelligent wie der Code

Maschinen hingegen sind nur so intelligent, wie ihre Programmierung es erlaubt. Welche Möglichkeiten es dabei gibt, zeigen vor allem Cobots. Im Gegensatz zu altbekannten Industrierobotern stellen sie eine platzsparende und erschwingliche Automatisierungslösung dar. Sie können Arbeitskräfte beispielsweise unterstützen, indem sie repetitive Aufgaben übernehmen. Dabei verleihen Vision-Systeme kollaborierenden Robotern einen eigenen Sehsinn und befähigen sie, komplexere Aufgaben zu übernehmen. Noch bis vor wenigen Jahren waren Bildverarbeitungssysteme teuer und nur von Fachleuten programmierbar.

Der sehende Roboter

Zwar leisten Cobots auch ohne Bildverarbeitung hervorragende Arbeit. Allerdings ist es vergleichsweise aufwendig, ‚blinde‘ Applikationen beispielsweise für Pick-and-Place-Aufgaben zu programmieren: Damit ein Roboter weiß, wo genau sich ein Gegenstand befindet, muss der Anwender ihm das Zielobjekt jedes Mal in genau derselben Ausrichtung und am selben Ort präsentieren. Um Zufälligkeiten auszuschließen, müssen oft zusätzliche Vorrichtungen wie Wendelförderer installiert werden. Vision-Systeme ermöglichen dem Roboter, selbst zufällig angeordnete Objekte zu verorten und sie präziser zu greifen. Zudem können Cobots mithilfe von Bildverarbeitungsprogrammen schnell zwischen verschiedenen Werkstücken wechseln, was die Umrüstzeiten senkt. Kosten für die Installation zusätzlicher Zuführvorrichtungen entfallen.

Wie funktioniert’s?

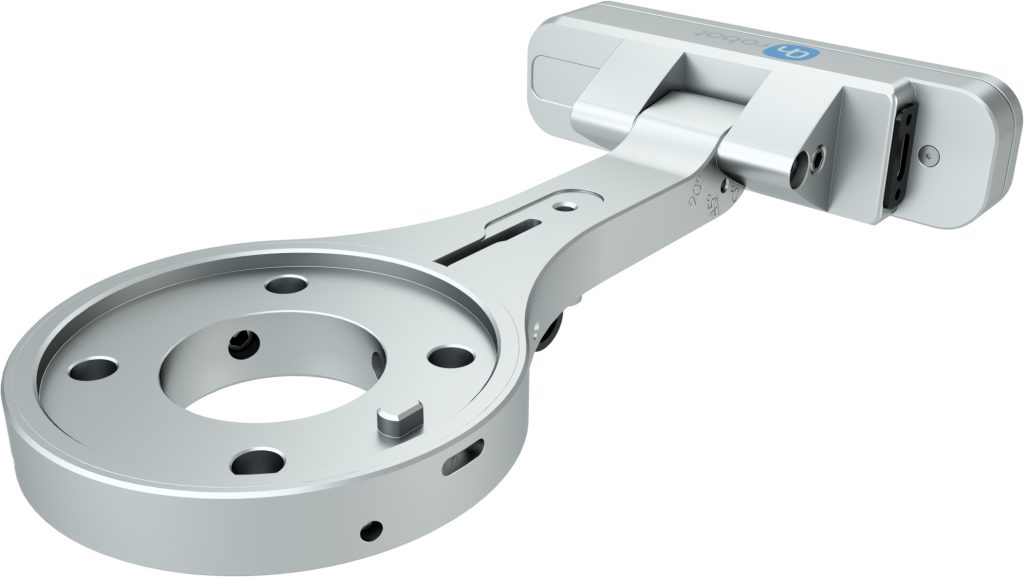

Doch wie funktioniert ein solches System? In der Regel sind Vision-Systeme PC-basiert, nehmen Bilder über eine oder mehrere Kameras auf und digitalisieren die Daten anschließend. Da Cobots über eine begrenzte Rechenleistung verfügen, müssen Hersteller von Vision-Systemen andere Lösungen für die Verarbeitung der Daten finden. So bietet beispielsweise OnRobot das Kameraprogramm zusammen mit der Vision-Lösung Eyes an. An den Cobot angeschlossen, lassen sich die Grundfunktionen über einen Webbrowser programmieren. Wird mit objektbasierter Erkennung gearbeitet wird die Kamera zunächst mit einer speziellen Messplatte auf den Arbeitsbereich kalibriert und im Anschluss das Werkstück erlernt. Bei der Verwendung von Features wie Landmark-Kalibrierung, Colour und Blob Detection sind viele Vision-Systeme in der Lage, Objekte allein anhand ihrer Farbe und Form zu identifizieren. Dabei genügt es, alle relevanten Informationen zu den Eigenschaften des Gegenstandes in das System einzuspeisen. Das Teaching entfällt und Anwender sparen Zeit bei der Programmierung. Die Eye-Box gibt die Position des Werkstücks an den Roboter weiter, der dann auf einen entsprechenden Trigger-Befehl hin reagiert und das Werkstück an den nächsten Arbeitsschritt weitergibt oder im Falle eines Fehlers aussortiert.