Für eine zuverlässige räumliche und zeitliche Verfolgung von Objekten reichen eine einfache Vorverarbeitung und ein einfacher Objekterkennungsalgorithmus nicht aus, um eine präzise Lokalisierung einschließlich einer Vorhersage der zukünftigen Position in Echtzeit zu ermöglichen. Häufig ist es auch erforderlich, aufgrund der Ergebnisse weitere Aktionen einzuleiten, z.B. einen Automation-Aktor auszulösen. Daher müssen solche Systeme auch so konzipiert werden, dass sie alle zusätzlichen Anforderungen des Pre- und Postprocessings erfüllen. Hierzu gehören die gleichzeitige Erfassung von Videobildern von mehreren Kameras einschließlich der Informations-/Zeitsynchronisation zwischen den verschiedenen Sensoren, die parallele Ausführung mehrerer Verarbeitungsschritte, wie Bildskalierung, -aggregation und -formatierung, Objekterkennung/-segmentierung und -Klassifizierung für jedes Einzelbild sowie die 3D-Objektverfolgung zuzüglich der Algorithmen zur ereignis- und zweckabhängigen Entscheidungsfindung.

Lösungsanbieter und Integratoren, die sich mit der KI-basierten Erkennung, Klassifizierung und Verfolgung von bewegten Objekten mit mehreren Kameras befassen, können Systeme auf Basis solcher SoCs jedoch nur mit hohem Aufwand vollständig selbst entwickeln. Sie benötigen applikationsfertige Lösungsplattformen, die je nach Bedarf an die konkrete Anwendung angepasst werden können. Hier bieten Systeme auf der Basis der industriellen Computerstandards der PICMG und VITA mit ihrem leistungsfähigen Ökosystem einen zuverlässigen Lösungsansatz.

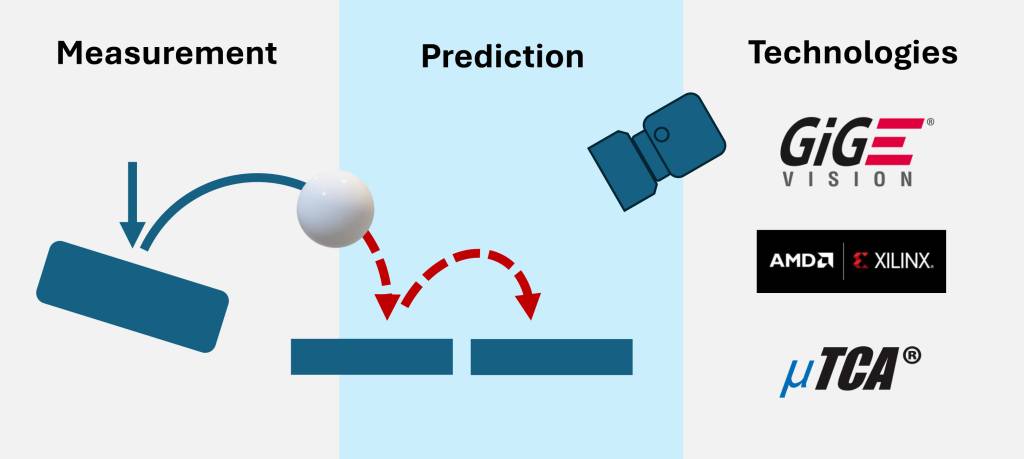

Bild 2 | Die NATvision Plattform ist für die Echtzeitdatenverarbeitung mehrerer hochauflösender Kameras konzipiert. – Bild: N.A.T. GmbH

Bild: N.A.T. GmbH

Hybride Plattform

Die NATvision-Plattform von N.A.T. ist eine Lösung, die diese Anforderungen erfüllt. Sie ermöglicht bereits in der kleinsten Ausbaustufe den Anschluss von bis zu vier GigEVision-Kameras über eine FMC-Mezzanine-Karte mit vier 1GbE PoE RJ45-Ports, wodurch Kameraunabhängigkeit und Sensorfusion erreicht werden. Das FMC ist auf einer Carrierkarte mit einem Xilinx Zynq Ultrascale Plus ZU7 FPGA montiert, der Cortex A53-Cores mit Petalinux integriert und Tools wie Python und OpenCV unterstützt. Der FPGA synchronisiert sich über eine passive Backplane mit anderen internen oder externen Systemelementen und ermöglicht so eine systemweite Echtzeitkommunikation auf einheitlichem Takt. Ein Intel CPU Board ist für das Post-Processing und zusätzliche Aufgaben integriert. Die Plattform verfügt über einen eigenen Geschwindigkeitstransparenten GigEVision Stack, ein GenICam Interface und unterstützt IEEE1588/PTP Zeitsynchronisation. Die Videovorverarbeitung findet im FPGA statt, um alle intensiven Prozessschritte mit minimaler Latenz auszuführen. Die verarbeiteten Daten werden im internen Speicher abgelegt und stehen einer Deep Learning Processor Unit (DPU) für Echtzeit-KI-Aufgaben zur Verfügung. Fortgeschrittene Sensorfusion und 3D-Objektverfolgung werden implementiert, wobei komplexe Nachbearbeitungsaufgaben auf eine separate CPU ausgelagert werden, um die Echtzeitfähigkeit zu gewährleisten. Dieses hybride Design der Processing-Cores verbessert die Leistung, reduziert Latenzzeiten und bietet eine hohe Flexibilität für KI-gesteuerte Vision-Anwendungen in Echtzeit. Individuelle Systemkonfigurationen für bis zu zwölf FPGA-Karten / 48 Kameras sind möglich, wobei sich das System für die Anbindung von Kameras mit einem Datendurchsatz von 1GbE bis 100GbE eignet.

www.nateurope.com