Entsprechend ihrer Bedeutung genießen IT-Ausfälle sowohl unternehmensintern als auch in der Öffentlichkeit große Aufmerksamkeit. Mittlerweile sind ungeplante IT-Stillstände in Unternehmen sowie deren Folgen und Kosten ein mediales Dauerthema. Dabei dominieren vorwiegend Ausfälle aufgrund von Cyberangriffen die Diskussion, etwa Denial-of-Service-Attacken, Kennwort- und Phishing-Angriffe sowie Schadsoftwarevorfälle mit und ohne Lösegeldforderungen. Weniger Beachtung findet die Tatsache, dass mindestens die Hälfte der IT-Ausfälle in den deutschen Unternehmen schlichtweg physische Ursachen hat. Sie werden hervorgerufen durch Übertemperatur der IT-Infrastruktur, Netzausfall oder USV-Defekte, durch Schmorbrände und Feuer, Wasser, Stromüberlastung oder Einbrüche. Im Unterschied zu IT-Downtimes, denen Softwarefehler zugrunde liegen, dauern die Ausfallzeiten bei physischen Defekten meist länger und sie erzeugen auch höhere Kosten.

Paradigmenwechsel

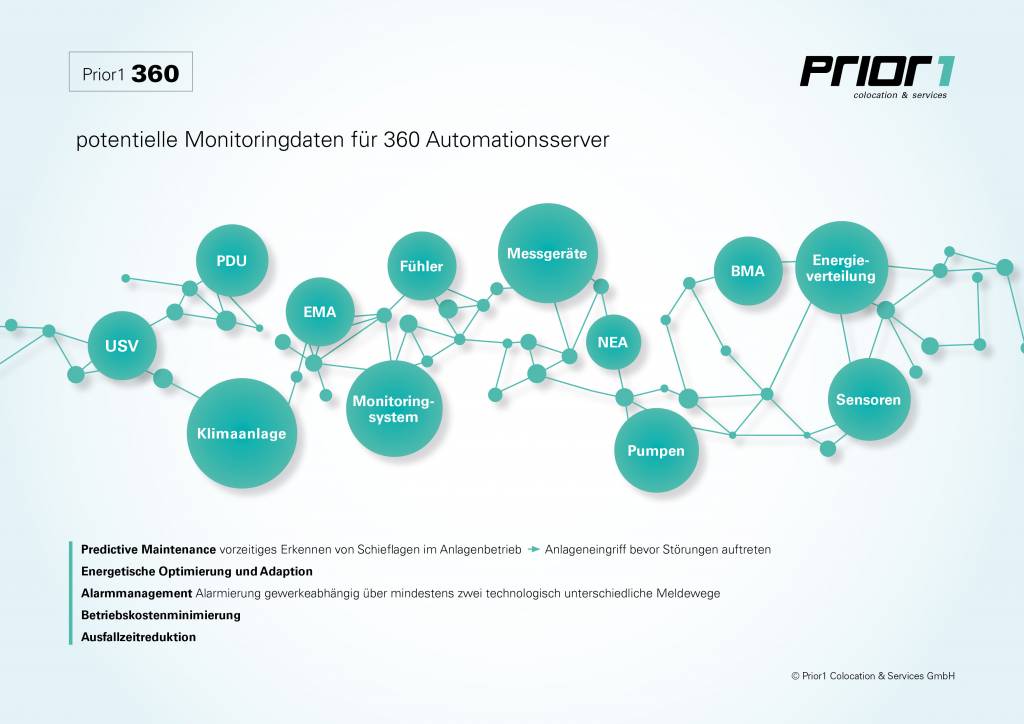

Moderne Rechenzentren sind hoch komplexe Bereiche, was die Anforderungen an ihre Verwaltung, die Absicherung und ihre Überwachung deutlich erhöht. Dennoch ist ein ausgeklügeltes Monitoring essenziell, dient es doch dazu, das Geschäft aufrecht zu erhalten. Überwacht werden muss nicht nur die IT-Infrastruktur, also Server, Speicher und Netzwerk-Switches, sondern auch die Rechenzentrumsinfrastruktur, zu der etwa die Stromverteilungseinheiten, Generatoren, Klimageräte, Ventilatoren oder HLK- (Heizung Lüftung Kühlung) Geräte gehören. Nach wie vor ist das Infrastruktur-Monitoring in vielen Unternehmen auf einen rein reaktiven Betrieb ausgerichtet. Erkennt das Monitoring-System ein Problem, erhält der firmeninterne IT-Administrator eine E-Mail und kann die nötigen Schritte setzen. Gelöscht wird, sobald ein Feuer ausgebrochen ist. Ein modernes Monitoring aber muss nicht nur in Echtzeit erfolgen und eine angemessene Reaktion auf Vorkommnisse ermöglichen, sondern datenbasiert und vorausschauend sein. Messdaten müssen präventiv erfasst, gespeichert, berechnet, analysiert und genutzt werden. IT-Ausfälle sollen idealerweise nicht nur schnell behoben werden, sondern erst gar nicht entstehen. Neben der Überwachung hat das Monitoring zudem die Aufgabe, Optimierungen im Rechenzentrum auf Basis der Messdaten zu ermöglichen.

Vollautomatisiert, proaktiv überwachen

Laut einer 2019 veröffentlichten weltweiten Umfrage von LogicMonitor unter 300 Entscheidungsträgern im IT-Bereich ließe sich über die Hälfte aller Infrastruktur-Ausfälle vermeiden. Voraussetzung: Unternehmen müssen entsprechende Warnsignale rechtzeitig und zuverlässig erkennen können. Die notwendigen Lösungen dafür sind bereits am Markt. Moderne Monitoring-Systeme, wie zum Beispiel die Monitoring-Lösung 360 von Prior1, fungieren nicht nur als Alarmsystem bei Vorfällen, sondern auch als Frühwarnsystem bei Risiken und helfen beim Entdecken von Schwachstellen oder Engpässen. Sie erlauben eine effizientere Steuerung des Rechenzentrums und ermöglichen dadurch den gezielten Kapazitätseinsatz sowie Kosteneinsparungen. Sensor-gestützt lässt sich mit ihnen jeder Teilbereich eines Rechenzentrums permanent überwachen und somit auch optimieren.

Knowhow und Service

Bei der Auswahl der relevanten Messdaten sollten erfahrene Spezialisten Unterstützung leisten. Denn prinzipiell sind in einem Rechenzentrum mehr als 1000 Datenpunkte auswertbar. Allein bei einer Wasserpumpe könnten 30 bis 40 Kriterien, Drehzahl, Druck, etc., überwacht werden. Es kommt also darauf an, die aussagekräftigsten Daten zu nutzen. Für Unternehmen, deren IT-Fachkräfte auch so schon mehr als ausgiebig beschäftigt sind, bietet sich die Full-Service-Variante des Monitorings an. Dabei wird die Planung und Umsetzung genauso übernommen wie der laufende Überwachungsbetrieb, der anhand von definierten Workflows automatisiert läuft. Ein Beispiel: Zeigen die von den Sensoren erfassten Werte eine Unregelmäßigkeit an, informiert das System nicht den internen IT-Administrator, wie es bei herkömmlichen Lösungen der Fall ist. Informiert wird die Serviceleitstelle des Monitoring-Partners. Diese arbeitet im 24/7 Betrieb und weiß, was im jeweiligen Fall zu tun ist. Dabei reichen die Maßnahmen von der Information des Wachdienstes vor Ort, der den Servicemitarbeiter ins Rechenzentrum einlässt, bis zur Begutachtung des aufgetauchten Verdachtsfalles oder zur Behebung des effektiven Vorfalles. Dadurch werden für die Überwachung des Rechenzentrums keine internen IT-Kapazitäten gebunden und dennoch alle wesentlichen Gefahren frühzeitig erkannt, gemeldet und bearbeitet, bevor es zu teuren Ausfällen kommt.