Überall dort, wo Automated Guided Vehicles (AGV) bzw. AMR zusammen mit Menschen gemeinsame Flächen benutzen, sind Sicherheitsvorkehrungen notwendig, die eine Gefährdung von Personen absolut zuverlässig verhindern. Hierzu sind praktisch in allen Fällen Sicherheits-Laserscanner in die Fahrzeuge integriert. Diese sind so installiert, dass sie Hindernisse in rund 20cm Höhe erkennen. Dies ermöglicht zwar einen sicheren Personenschutz, andere Hindernisse, die oberhalb oder unterhalb des Erfassungsbereichs des Scanners liegen, werden so aber nicht erkannt. Typische Kollisionen passieren daher z.B. mit nicht vollständig geöffneten Rolltoren, Regalen, Absperrgittern, angehobene Zinken eines Gabelstaplers, Gitterboxen, Plattform-Steigern und ähnlichen Gegenständen, die oberhalb des Erkennungsbereichs liegen. Auch auf dem Boden befindliche Hindernisse werden nicht erkannt. Dies können beispielsweise Absätze und Stufen sein aber auch die bis zum Boden abgesenkten Zinken des Gabelstaplers oder eine leere Palette.

Weitere Sensoren, die im AGV oder AMR verbaut werden, können die Sicherheit gegenüber Kollisionen deutlich verbessern. Gleichzeitig muss die Steuerungssoftware aber auch in der Lage sein, diese Daten zu verarbeiten, um so die passenden Aktionen auszuführen. Es können verschiedene physikalische Sensor-Prinzipien wie Ultraschall oder Radar verwendet werden, auch Kameras spielen beim Wahrnehmen der Umgebung eine wichtige Rolle. Insbesondere 3D-ToF-Kameras bieten enorme Vorteile. In der Vergangenheit waren solche Kameras vergleichsweise teuer, und die Software zur Bildverarbeitung war anspruchsvoll und verlangte entsprechendes Know-how während der Entwicklung.

Einen neuen Ansatz bietet das Perception-System O3R von ifm. Das Unternehmen stellt damit eine Hardware-Plattform zur Verfügung, die auf einer zentralen Video Processing Unit (VPU) basiert. An diese lassen sich über FPD-Link bis zu sechs Kameraköpfe verbinden. Zusätzliche Sensoren beispielsweise Radar oder Lidar können über eine GigE-Schnittstelle angeschlossen werden. Die Kameraköpfe können im Fahrzeug flexibel eingebaut und angeordnet werden. Somit lässt sich die gesamte Umgebung lückenlos erfassen. Da die Rechenleistung überwiegend von der VPU zur Verfügung gestellt wird, können die Kameras entsprechend einfacher ausgelegt und damit kostengünstiger angeboten werden. ifm bietet die passenden Kameras, die 3D-Sensoren oder eine Kombination aus 3D- und 2D-Sensoren mit verschiedenen Öffnungswinkeln und Auflösungen.

Software einfach implementieren

Die VPU der O3R-Plattform ist ein auf Nvidia basierendes Linux-System. Da die Leistungsfähigkeit skalierbar ist, kann sie auf die jeweilige Applikation angepasst werden. Die meisten der auf der Plattform laufenden Anwendungen nutzen eine Sensordatenfusion. Mit diesen Informationen können dann AGV und AMR optimiert betrieben werden. Dank der verfügbaren ROS2-Treibern lässt sich das System einfach in Robotik-Applikationen integrieren. Sowohl für die Vorentwicklung als auch die Serienentwicklung stellt ifm umfangreiche Software-Tools sowie Entwicklungsplattformen zur Verfügung. Zugang erhalten Entwickler über die O3R-Website (www.O3R.ifm.com) sowie über Github.

Obstacle Detection System

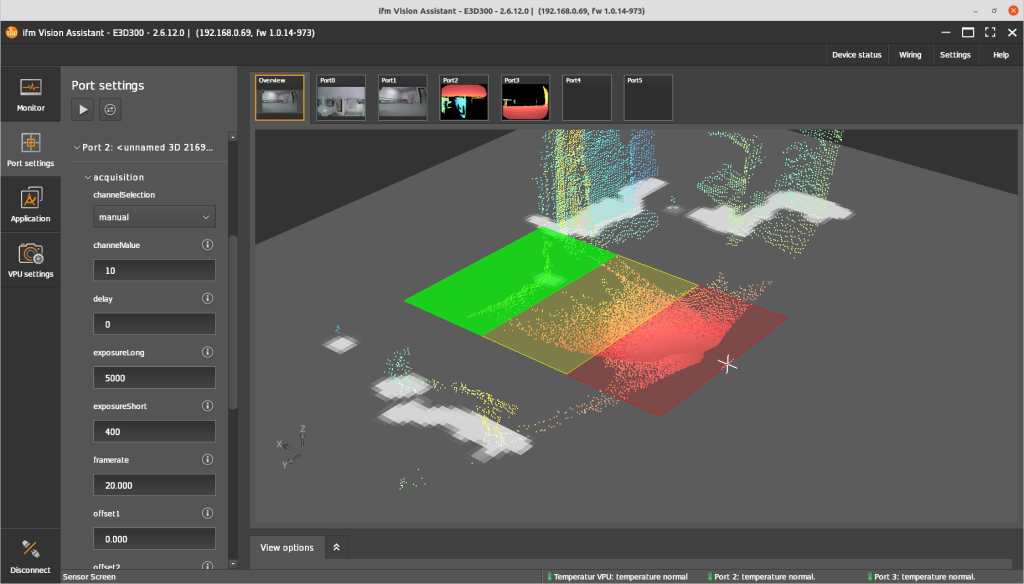

Um Anwendungen möglichst einfach umsetzen zu können, bietet ifm zudem mit seinem Vision Assistant eine Lösung, in der zahlreiche typische Aufgaben bereits fertig implementiert sind. Die Idee dahinter: möglichst viele Funktionen sollen durch einfache Parametrierung erledigt werden. Eine neue Funktion für die O3R-Plattform ist das Obstacle Detection System (ODS). Dieses erkennt Hindernisse, die sich auf dem Weg des AGV oder AMR befinden. Im Gegensatz zu einem einfachen Sicherheits-Laserscanner ist der Erfassungsbereich aber nicht auf die Knöchelhöhe limitiert. Der Algorithmus im ODS ist so konzipiert, dass er möglichst sicher und zuverlässig Objekte erkennt. Verwendet wird dabei ein Occupancy Grid eine Art Schachbrettdarstellung der Umgebung mit Belegterkennung pro Schachfeld der Größe 5x5cm, oder Zonen, in denen Bereiche in Form von Polygonen definiert werden können. Diese werden je nach Fahrtrichtung, Geschwindigkeit und Lenkbewegungen dynamisch angepasst, so wie man es etwa von Rückfahrkameras in PKW kennt. Dazu ist eine Kommunikation zwischen O3R und der Fahrzeugsteuerung notwendig. Gleichzeitig wurde bei der Entwicklung Wert darauf gelegt, dass es möglichst nicht zu Fehlerkennungen kommt. Indem jedes Objekt mehrfach hintereinander erkannt werden muss, unterdrückt das System Artefakte, die durch Staub oder Dunst im Sichtfeld der Kamera entstehen könnten. Generell kann die Empfindlichkeit des Systems angepasst werden, um Fehlerkennungen zu vermeiden.

Problemfall Bodenerkennung

Um das ODS einzurichten, müssen die Kameras ausgewählt und deren Positionen am Fahrzeug festgelegt werden. Die Kalibrierung des Systems erfolgt mit Hilfe eines Wizards im Vision Assistant und handelsüblicher Kalibrierplatten in Schachbrettmuster. Die für den Anwendungsfall wichtige Erkennung des Bodens – oder besser die Trennung von Boden und Objekten auf dem Boden – ist hierbei der eigentliche Kern der Lösung. Der Clou liegt in der visuellen Odometrie, bei dem die Kameras hinreichend markante Strukturen auf dem Boden erfassen. Unterstützt wird dies durch einen in der O3R-Plattform integrierten Inertialsensor (IMU). Alternativ können die Eigenbewegungsdaten des Fahrzeugs genutzt werden, um Boden, Bewegungsartefakte und bewegte Objekte voneinander zu unterscheiden. ifm hat mit verschiedenen Leitkunden Entwicklungs-Partnerschaften vereinbart. Diese bieten den Kunden die Möglichkeit, das System in einer relativ frühen Phase zu verwenden und auf ihre Anforderungen anpassen zu lassen. Im Gegenzug liefern diese Betriebsdaten des Systems, mit denen ifm die Algorithmen weiter optimieren kann.